![]()

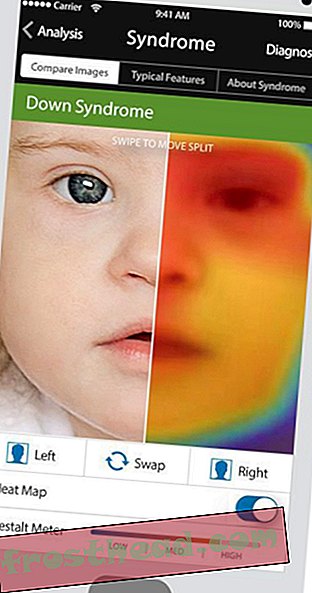

Gesichtsanalyse bei der Arbeit. Mit freundlicher Genehmigung von Affectiva

So viel Zeit wir mit unseren Handys, Laptops und Tablets verbringen, es ist immer noch so ziemlich eine einseitige Beziehung. Wir handeln, sie antworten. Sicher, Sie können mit Siri auf Ihrem iPhone ein Gespräch führen, und obwohl sie schnell ist, ist es kaum als spielerisches Geplänkel zu bezeichnen. Sie stellen Fragen, sie gibt Antworten.

Aber was wäre, wenn diese Geräte unsere Emotionen wirklich lesen könnten? Was wäre, wenn sie jede kleine Geste, jeden Gesichtsausdruck so interpretieren könnten, dass sie unsere Gefühle sowie - vielleicht sogar besser als - unsere besten Freunde einschätzen können? Und dann antworten sie, nicht mit Informationen, sondern was als Empathie gelten könnte.

Wir sind noch nicht da, aber wir bewegen uns schnell in diese Richtung, angetrieben von einem Gebiet der Wissenschaft, das als Affective Computing bekannt ist. Es basiert auf Software, die menschliche Gefühle messen, interpretieren und darauf reagieren kann. Dies kann bedeuten, dass Sie Ihr Gesicht mit der Kamera erfassen und dann Algorithmen auf jeden Aspekt Ihrer Ausdrücke anwenden, um zu versuchen, jedes Grinsen und jede Kinnunebenheit zu verstehen. Oder es kann sein, dass Sie Ihre Belästigung oder Ihr Vergnügen ablesen, indem Sie nachverfolgen, wie schnell oder mit welcher Kraft Sie auf einen Text tippen oder ob Sie Emoticons verwenden. Und wenn Sie zu aufgeregt - oder betrunken - scheinen, könnten Sie eine Nachricht erhalten, in der Sie darauf hingewiesen werden, dass Sie das Drücken des Sendesymbols unterbrechen möchten.

Angesichts der Tatsache, wie schwierig es für uns Menschen ist, andere Menschen zu verstehen, ist diese Vorstellung, Maschinen zum Lesen unserer Gefühle zu programmieren, keine leichte Herausforderung. Aber es nimmt Fahrt auf, da sich die Wissenschaftler verstärkt auf die emotionale Intelligenz der Lerngeräte konzentrieren.

Jede Bewegung, die Sie machen

Eines der besseren Beispiele für die Funktionsweise von affektivem Computing ist der Ansatz eines Unternehmens mit dem Namen Affectiva. Es zeichnet Ausdrücke auf und überprüft dann mithilfe proprietärer Algorithmen die Gesichtsmerkmale. Dabei greift es auf eine Datenbank mit fast 300 Millionen Einzelbildern von Elementen menschlicher Gesichter zu. Die Software wurde so verfeinert, dass sie verschiedene Kombinationen dieser Elemente mit unterschiedlichen Emotionen verknüpfen kann.

Bei der Entwicklung im MIT Media Lab durch die beiden Wissenschaftler Rosalind Picard und Rana el Kaliouby wurde die als Affdex bekannte Software entwickelt, um autistischen Kindern eine bessere Kommunikation zu ermöglichen. Aber es hatte eindeutig ein großes Potenzial in der Geschäftswelt, und so hat MIT das Projekt in eine private Firma ausgegliedert. Seitdem wurden 21 Millionen US-Dollar von Investoren aufgebracht.

Wie wird Affdex eingesetzt? Meistens sieht man Leute, die Werbung sehen. Es zeichnet Personen auf, die Anzeigen auf ihrem Computer anzeigen - keine Sorge, Sie müssen sich dafür entscheiden - und wertet dann auf der Grundlage der Datenbank mit Gesichtsweisen aus, wie sich die Zuschauer über das, was sie gesehen haben, fühlen. Und die Software liefert nicht nur ein allgemeines positives oder negatives Urteil. Die Reaktionen der Zuschauer werden Sekunde für Sekunde aufgeschlüsselt, wodurch die Werbetreibenden präziser als je zuvor erkennen können, was in einem Werbespot funktioniert und was nicht.

Es ist auch in der Lage zu sehen, dass die Menschen, während sie eines sagen, ein anderes sagen können. In einem Interview mit der Huffington Post gab el Kaliouby das Beispiel für die Reaktion auf eine Anzeige für Körperlotion, die in Indien ausgestrahlt wurde. Während der Werbung berührt ein Ehemann spielerisch den freiliegenden Bauch seiner Frau. Danach sagten einige Frauen, die es gesehen hatten, dass sie diese Szene als anstößig empfanden. Doch laut El Kaliouby zeigten die Videos der Zuschauer, dass jede der Frauen auf die Szene mit einem sogenannten „Genusslächeln“ reagierte.

Sie sieht Möglichkeiten jenseits der Welt der Werbung. Smart-TVs könnten so viel intelligenter sein, wenn sie in der Lage sind, eine Speicherbank für unsere Gesichtsausdrücke zu entwickeln. Und Politiker könnten in Echtzeit auf jede Zeile reagieren, die sie während einer Debatte äußern, und ihre Botschaften im laufenden Betrieb anpassen. Außerdem, sagt El Kaliouby, könnte es Gesundheitsanwendungen geben. Sie sagt, es ist möglich, die Herzfrequenz einer Person mit einer Webcam zu lesen, indem der Blutfluss in ihrem Gesicht analysiert wird.

"Stellen Sie sich vor, Sie haben die ganze Zeit eine Kamera, die Ihre Herzfrequenz überwacht", sagte sie gegenüber der Huffington Post, "damit Sie feststellen können, ob etwas nicht stimmt, ob Sie fit werden müssen oder ob Sie die Stirn runzeln." Zeit und müssen sich entspannen. "

Also, was denkst du, gruselig oder cool?

Tracking-Geräte

Hier sind fünf weitere Möglichkeiten, wie Maschinen auf menschliche Emotionen reagieren:

- Und wie war mein Tag ?: Forscher an der Universität von Cambridge haben eine Android-App für Mobilgeräte entwickelt, mit der das Verhalten einer Person über den Tag hinweg überwacht werden kann. Dabei werden eingehende Anrufe und Texte sowie Social-Media-Posts verwendet, um ihre Stimmung zu verfolgen. Die App mit dem Namen "Emotion Sense" wurde entwickelt, um eine "Entdeckungsreise" zu ermöglichen, mit der Benutzer die Gipfel und Täler ihres täglichen Lebens digital aufzeichnen können. Die Daten können gespeichert und für Therapiesitzungen verwendet werden.

- Und das bin ich nach der dritten Tasse Kaffee: Dann gibt es noch Xpression, eine weitere Mood-Tracking-App, die von einer britischen Firma namens EI Technologies entwickelt wurde. Anstatt sich auf Therapeuten zu verlassen, um Tagebücher über Stimmungsschwankungen zu führen, überprüft die App, ob sich eine Person in einem der fünf emotionalen Zustände befindet: ruhig, glücklich, traurig, wütend oder ängstlich / ängstlich. Anschließend wird eine Liste der Stimmungen und Veränderungen einer Person erstellt. Und wenn die Person es wünscht, kann diese Aufzeichnung am Ende eines jeden Tages automatisch an einen Therapeuten gesendet werden.

- Was, wenn Sie es einfach hassen, auf einem Telefon zu tippen? : Wissenschaftler von Samsung arbeiten an einer Software, die Ihre Einstellung daran misst, wie Sie Ihre Tweets auf Ihrem Smartphone eingeben. Indem Sie analysieren, wie schnell Sie tippen, wie oft das Telefon wackelt, wie oft Sie Fehler bei der Rücktaste machen und wie viele Emoticons Sie verwenden, sollten Sie feststellen können, ob Sie wütend, überrascht, glücklich, traurig, ängstlich oder angewidert sind. Und basierend auf der Schlussfolgerung, die es zieht, könnte es mit Ihrem Tweet das passende Emoticon enthalten, um Ihre Follower auf Ihren Geisteszustand hinzuweisen.

- Laden Sie Ihre Freunde nicht zum Zuschauen ein: Mit einem Sensor am Handgelenk und einer Smartphone-Kamera am Nacken haben Forscher des MIT ein „Lebenserfassungssystem“ entwickelt, das Bilder und Daten sammelt, um einer Person zu zeigen, welche Ereignisse dargestellt wurden ihre emotionalen Höhen und Tiefen. Das System mit der Bezeichnung Inside-Out enthält einen Biosensor in einem Armband, der die erhöhten Emotionen durch elektrische Aufladungen in der Haut aufzeichnet, während das Smartphone den Standort der Person verfolgt und mehrere Fotos pro Minute macht. Am Ende des Tages kann der Benutzer dann seine Erfahrungen zusammen mit allen Sensordaten anzeigen.

- Ihre Stirn sagt, Sie haben Probleme: Dies war wahrscheinlich unvermeidlich. Forscher der University of Southern California haben einen Robotertherapeuten entwickelt, der nicht nur dazu programmiert ist, Patienten mit zeitlich gut abgestimmten „Uh-huhs“ zu ermutigen, sondern auch Experten ist, die mithilfe von Bewegungssensoren und Stimmanalyse jede Geste und Stimme eines Patienten interpretieren Beugung während einer Therapiesitzung.

Videobonus: Möchten Sie sehen, wie bizarr dieser Trend bei Geräten ist, die menschliche Emotionen lesen? Schauen Sie sich diese Aktion von Tailly an, einem mechanischen Schwanz, der Ihre Erregung aufnimmt, indem er Ihre Herzfrequenz erfasst und dann entsprechend wedelt.

Mehr von Smithsonian.com

Dieser neue Roboter hat einen Tastsinn

Kochen mit Robotern