Wenn Sie etwas greifen, erledigt Ihre Hand den größten Teil der Arbeit. Ihr Gehirn sagt nur: "Geh, du machst dir keine Sorgen darüber, wie es passiert." Bei einer selbst fortgeschrittenen Prothese erfordert diese Aktion jedoch viel mehr Intentionalität. Infolgedessen verlassen viele Patienten ihre hochmodernen Gliedmaßen.

Verwandte Inhalte

- Wie das Hacken neuronaler Netze Amputierten dabei helfen kann, ein Ei fehlerfrei zu knacken

- Die Prothese zu bekommen ist einfach im Vergleich zu dem, was Sie wollen

Moderne Prothesen erhalten Befehle in Form von elektrischen Signalen von den Muskeln, an denen sie befestigt sind. Aber auch die beste Prothetik kann noch nicht viel. Benutzer benötigen eine lange Einarbeitungszeit, um sich an die Extremität zu gewöhnen. Sie können sich oft nur begrenzt bewegen, und Benutzer müssen manuell zwischen den Griffen wechseln, um verschiedene Aufgaben zu erledigen, z. B. um eine Tür zu öffnen oder einen Schlüssel zu drehen. Alles in allem bedeutet dies, dass die Hand nicht nahtlos mit dem Gehirn zusammenarbeiten kann.

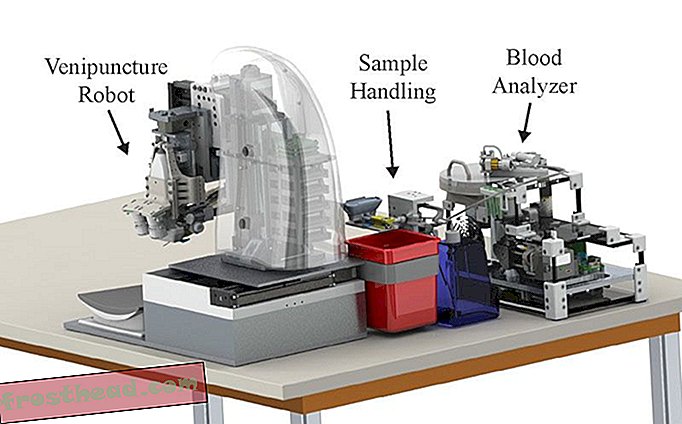

Ein Werkzeug, das zur Lösung dieses Problems beitragen könnte, ist Computer Vision. Forscher der Newcastle University montierten eine Webcam an einer Handprothese, schlossen sie an ein tiefes neuronales Lernnetz an und gaben die Geräte zwei Amputierten, deren Arme über dem Handgelenk, aber unter dem Ellbogen amputiert worden waren. Der Computer benutzte die Kamera, um zu sehen, wonach der Benutzer griff, und stellte den Griff der Prothese automatisch ein.

Die Ergebnisse waren bisher vielversprechend. In einem Artikel im Journal of Neural Engineering berichtete das Team aus Newcastle, dass die Benutzer Erfolgsraten für das Aufheben und Bewegen von Objekten von über 80 Prozent hatten.

"Wenn wir das verbessern können, hundertprozentig, wäre es viel zuverlässiger, die Hand für die Amputierten zu verwenden", sagt Ghazal Ghazaei, Doktorand in Newcastle und Hauptautor der Zeitung im wirklichen Leben verwendet, sollte es fehlerfrei sein. "

Das Gerät selbst war eine handelsübliche Prothese, die als i-limb ultra bezeichnet wurde, und die Webcam war ein kostengünstiger Logitech Quickcam Chat mit niedriger Auflösung. Die eigentliche Innovation bestand darin, wie Ghazaeis Team ein Computerlernschema entwickelte, um die Informationen der Webcam zu nutzen.

Die Software erkennt Muster in der Form des zu hebenden Objekts und klassifiziert sie in Kategorien, basierend auf dem Griff, den sie benötigt, um sie effektiv zu erfassen. Um dem Computer diese Technik beizubringen, fütterte Ghazaei ihn mit jeweils 72 Bildern, die in Schritten von 5 Grad von 500 Objekten aufgenommen wurden. Die Software filtert die Objekte nach ihren Merkmalen und lernt durch Ausprobieren, welche in welche Kategorien fallen.

Wenn der Prothese dann ein Objekt präsentiert wird, klassifiziert das Netzwerk das Bild mit niedriger Auflösung anhand seiner breiten, abstrakten Form. Es muss nichts sein, was das System zuvor gesehen hat - die allgemeine Form des Objekts reicht aus, um der Hand mitzuteilen, welchen Griff sie verwenden soll. Ghazaei und sein Team verwendeten vier Grifftypen, darunter Prise (zwei Finger), Stativ (drei Fingerspitzen), neutrale Handfläche (wie das Ergreifen einer Kaffeetasse) und pronierte Handfläche (wobei die Handfläche nach unten zeigt).

Computer Vision wurde bereits in Roboterhänden eingesetzt, sowohl in der Prothetik als auch in Industrierobotern. Diese Bemühungen betrafen jedoch entweder Objekte mit Standardgröße und -form wie in einer Fertigungsumgebung oder langsamere Algorithmen. Das in Newcastle entwickelte System war in der Lage, diesen Prozess schnell genug zu durchlaufen, um die Objekte in 450 Mikrosekunden oder etwa 1 / 2000stel Sekunden korrekt zu klassifizieren. „Der Hauptunterschied besteht in der Zeit, die erforderlich ist, um die Aufgabe zu erfassen und zu erledigen“, sagt Ghazaei. „Für einige von ihnen sind es ungefähr vier Sekunden, und einige von ihnen benötigen mehrere Schnappschüsse. Für uns ist es nur ein Schnappschuss und es ist sehr schnell. “

Die Auswirkungen dieser Technologie gehen weit über das Aufheben von Haushaltsgegenständen hinaus. Bildgebende Systeme könnten Prothesenbeinen helfen, den Abstand zum Boden zu ermitteln und beispielsweise eine entsprechende Anpassung vorzunehmen. Gemeinsam ist beiden Fällen ein Robotersystem, das in Verbindung mit dem Gehirn arbeitet.

"Die Hauptidee ist eine Interaktion zwischen dem Roboter und dem Menschen, die dem Robotersystem etwas Intelligenz verleiht", sagt Dario Farina, Professor für Neurorehabilitationstechnik am Imperial College London, dessen Labor neuromuskuläre Schnittstellen für Körper und Gehirn untersucht die Geräte, mit denen sie verbunden sind.

"Es ist nicht nur der Patient, der mit seinem Gehirn und über die neuronale Schnittstelle die Prothese steuert, sondern es ist auch dem Patienten von einer zweiten intelligenten Einheit geholfen, die auf der Prothese montiert ist und die Umgebung sehen kann." Farnia, die nicht an der Newcastle-Studie beteiligt war: "Die größte Herausforderung besteht darin, die Kontrolle zwischen Mensch und Nachrichtensystem zu teilen."

Es ist ein früher Einstieg in die Verschmelzung von künstlicher Intelligenz mit dem Gehirn, um herauszufinden, welche Aktionen für jeden am besten funktionieren, ohne Konflikte zu verursachen. Ghazaei ist auf dieses Problem gestoßen; Sie arbeitet immer noch daran, zu steuern, wie viel von der breiten Bewegung vom Computer der Prothese im Vergleich zu den Aktionen des Benutzers gesteuert wird. Im Moment richtet der Benutzer die Prothese auf den Gegenstand, veranlasst ihn, ein Foto zu machen, und dann wählt der Arm den Griff und greift.

Es ist nur eine von vielen verbleibenden Herausforderungen. Im Moment kann das System keine langen Objekte verstehen, die außerhalb der Sichtweite liegen. Es hat Probleme mit überfüllten Hintergründen. Manchmal interpretiert es ein weiter entferntes Objekt als ein kleineres, näheres. Und Ghazaei sagt, es sei ein weiteres Ziel, die Anzahl der Greifertypen auf 10 oder 12 zu erhöhen. Aber bereits jetzt, so sagt sie, haben die beiden Benutzer in der Studie die Leistungssteigerung und die Einfachheit, die sie dem grundlegenden Vorgang des Aufnehmens von etwas verleiht, zu schätzen gewusst.