![]()

Mustererkennung eines Schmetterlingsflügels. Mit freundlicher Genehmigung von Li Li

Hier in Washington haben wir von dieser Sache gehört, die Sie "Vorausplanung" nennen, aber wir sind noch nicht bereit, sie anzunehmen. Ein bisschen zu futuristisch.

Dennoch können wir nicht anders, als diejenigen aus der Ferne zu bewundern, die versuchen, vorherzusagen, was in mehr als einem Monat passieren könnte. Ich war vor einigen Wochen beeindruckt, als die großen Denker von IBM die Welt in fünf Jahren vorstellten und herausfanden, von welchen fünf Innovationsbereichen sie glauben, dass sie den größten Einfluss auf unser tägliches Leben haben werden.

Sie machen das schon seit ein paar Jahren, aber dieses Mal folgten die Winseln einem Thema - den fünf menschlichen Sinnen. Nicht, dass sie sagen, dass wir bis 2018 alle in der Lage sein werden, besser zu sehen, zu hören und zu riechen, sondern eher, dass Maschinen - durch den Einsatz sich schnell entwickelnder sensorischer und kognitiver Technologien - ihre Transformation vom Datenabruf auf beschleunigen werden Motoren zu Denkwerkzeugen verarbeiten.

Muster sehen?

Beschäftigen wir uns heute mit der Vision. Es ist ein logischer Schritt anzunehmen, dass IBM möglicherweise auf Googles Project Glass verweist. Keine Frage, dass es die Rolle der Brille neu definiert hat, von ausgefallenem Accessoire, das uns hilft, besser zu sehen, bis hin zur Kombination von Smartphone / Datentauchgerät, das wir eines Tages auf unseren Gesichtern tragen werden.

Aber darüber reden die IBMer nicht. Sie konzentrieren sich auf die Bildverarbeitung, insbesondere auf die Mustererkennung, bei der Computer durch wiederholte Belichtung mit Bildern in der Lage sind, Dinge zu identifizieren.

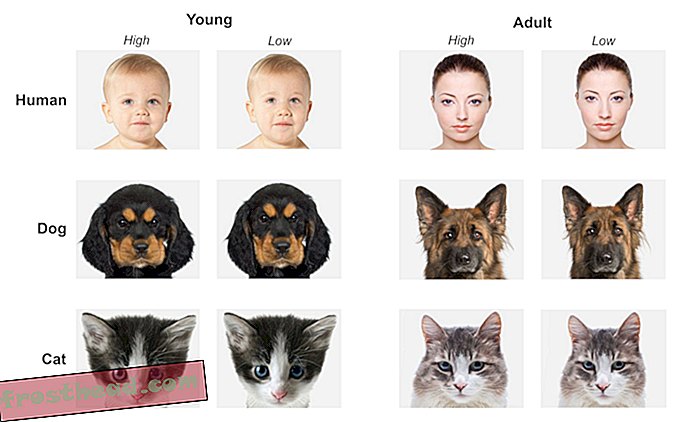

Wie sich herausstellte, war Google zufällig an einem der bemerkenswerteren Mustererkennungsexperimente des letzten Jahres beteiligt. In diesem Projekt konnte sich ein Netzwerk von 1.000 Computern mit 16.000 Prozessoren nach Prüfung von 10 Millionen Bildern aus YouTube-Videos selbst beibringen, was ein Katze sah aus wie.

Das Besondere daran: Die Computer konnten dies ohne menschliche Anleitung tun. Das gesamte Lernen wurde durch die Maschinen durchgeführt, die zusammenarbeiteten, um zu entscheiden, welche Merkmale von Katzen ihre Aufmerksamkeit verdienten und welche Muster von Bedeutung waren.

Und das ist das Modell dafür, wie Maschinen das Sehen lernen. So erklärt es John Smith, Senior Manager bei IBM Intelligent Information Management:

„Nehmen wir an, wir wollten einem Computer beibringen, wie ein Strand aussieht. Wir würden damit beginnen, dem Computer viele Beispiele für Strandszenen zu zeigen. Der Computer verwandelt diese Bilder in unterschiedliche Merkmale, wie z. B. Farbverteilungen, Texturmuster, Kanteninformationen oder Bewegungsinformationen im Falle von Videos. Dann würde der Computer lernen, wie man Strandszenen anhand dieser unterschiedlichen Merkmale von anderen Szenen unterscheidet. Es würde sich beispielsweise herausstellen, dass in einer Strandszene im Vergleich zu einem Stadtbild in der Innenstadt normalerweise bestimmte Farbverteilungen auftreten. “

Wie schlau ist schlau?

Gut für sie. Aber ehrlich gesagt, die Identifizierung eines Strandes ist für die meisten von uns Menschen ziemlich einfach. Könnten wir uns darüber hinreißen lassen, wie viel Denkmaschinen für uns tun können?

Gary Marcus, Psychologieprofessor an der New York University, ist der Meinung. Kürzlich schrieb er auf der New Yorker- Website, dass zwar große Fortschritte beim sogenannten „Deep Learning“ erzielt wurden, Maschinen jedoch noch einen weiten Weg vor sich haben, bevor sie als wirklich intelligent gelten sollten.

„Realistisch gesehen ist Deep Learning nur ein Teil der größeren Herausforderung beim Bau intelligenter Maschinen. Solche Techniken bieten keine Möglichkeit, kausale Zusammenhänge darzustellen (z. B. zwischen Krankheiten und ihren Symptomen), und sie stehen wahrscheinlich vor der Herausforderung, abstrakte Ideen wie „Geschwister“ oder „identisch mit“ zu erlangen. Sie haben keine offensichtlichen Möglichkeiten, logische Schlussfolgerungen zu ziehen, und sie sind auch noch weit davon entfernt, abstraktes Wissen zu integrieren, wie z. B. Informationen darüber, was Objekte sind, wofür sie sind und wie sie typischerweise verwendet werden. “

Die Leute bei IBM würden dies zweifellos anerkennen. Maschinelles Lernen erfolgt in Schritten, nicht in Sprüngen.

Sie glauben jedoch, dass Deep Learning innerhalb von fünf Jahren so weit fortgeschritten sein wird, dass Computer beispielsweise in der medizinischen Diagnostik eine viel größere Rolle spielen, dass sie tatsächlich besser als Ärzte werden könnten, wenn es darum geht, Tumore und Blutgerinnsel zu erkennen oder erkranktes Gewebe in MRT, Röntgen oder CT-Scans.

Und das könnte einen großen Unterschied in unserem Leben bewirken.

Sehen heißt glauben

Hier sind weitere Möglichkeiten, wie sich Bildverarbeitung auf unser Leben auswirkt:

- Den besten Arm nach vorne bringen: Die an der Universität von Pittsburgh entwickelte Technologie nutzt die Mustererkennung, um Querschnittslähmern die Steuerung eines Roboterarms mit dem Gehirn zu ermöglichen.

- Ihr Mund sagt ja, aber Ihr Gehirn sagt nein: Forscher von Stanford stellten fest, dass die Verwendung von Mustererkennungsalgorithmen bei MRT-Untersuchungen des Gehirns ihnen dabei helfen kann, festzustellen, ob jemand tatsächlich Schmerzen im unteren Rückenbereich hatte oder ob er sie vortäuschte.

- Wenn Ihre Maulwürfe für ihre Nahaufnahmen bereit sind: Im vergangenen Jahr hat ein rumänisches Startup namens SkinVision eine iPhone-App auf den Markt gebracht, mit der sich Maulwürfe auf ihrer Haut fotografieren lassen und die Erkennungssoftware von SkinVision Unregelmäßigkeiten erkennen und auf die Risikostufe hinweisen kann - ohne Angebot einer tatsächlichen Diagnose. Der nächste Schritt besteht darin, Menschen die Möglichkeit zu geben, Bilder ihrer Haut direkt an ihren Dermatologen zu senden.

- Habe ich einen Deal für Sie: Derzeit befindet sich eine Marketing-Technologie namens Facedeals in der Entwicklung. Das funktioniert so: Sobald eine Kamera am Eingang eines Geschäfts Sie erkennt, erhalten Sie auf Ihrem Smartphone maßgeschneiderte Angebote im Geschäft. Und ja, Sie müssten sich zuerst anmelden.

- Ich kenne dieses Siegel überall: Ein computergestütztes Foto-ID-System, das die Mustererkennung verwendet, hilft britischen Wissenschaftlern, graue Siegel mit eindeutigen Markierungen auf ihren Mänteln zu verfolgen.

Videobonus: Während wir uns mit künstlicher Intelligenz befassen, gibt es hier einen Roboterschwarm, der Beethoven spielt, ein Kompliment von Wissenschaftlern von Georgia Tech. Ich wette, das hast du heute nicht erwartet.

Mehr von Smithsonian.com

Ein menschlicheres künstliches Gehirn

Wie Technologie den Terrorismus bekämpft