Wenn Sie auf der Benutzeroberfläche einen leisen, Bluetooth-fähigen Clicker in der Größe eines Kaugummibündels verwenden, können Sie einen Computer auf ungewöhnliche Weise auswählen, bewegen, klicken oder auf andere Weise steuern. Aber für bestimmte Situationen macht es tatsächlich sehr viel Sinn. Angenommen, Sie fahren Fahrrad und möchten einen Anruf über Ihr Headset entgegennehmen oder eine Wegbeschreibung abrufen, möchten aber nicht die Hände von den Lenkern nehmen. Oder wenn Sie gelähmt sind und einen Elektrorollstuhl fahren müssen, ist ein unauffälliges Steuerkreuz in Ihrem Mund weitaus weniger auffällig als ein normales Mund- oder Kinnsteuergerät oder sogar eines, das Sie mit der Schulter drücken.

„Wie können wir diese Interaktionen reproduzieren und gleichzeitig die Diskretion der Benutzeroberfläche aufrechterhalten?“, Sagt Pablo Gallego, einer der Erfinder des Geräts mit dem Namen ChewIt. „Die Leute können nicht sagen, ob Sie mit ChewIt interagieren oder ob Sie Kaugummi oder Gummibärchen im Mund haben. Oder vielleicht ein Karamell. "

Gallego entschied sich für diese Idee und war entschlossen, sie zu verfeinern und einen Prototyp für seinen Master-Abschluss in Ingenieurwissenschaften an der neuseeländischen Universität von Auckland zu erstellen. Untersuchungen ergaben, dass Menschen im Mund unterschiedliche Formen erkennen können, ähnlich wie mit den Fingerspitzen. Und er wusste, dass wir Kaugummi und andere Fremdkörper vertragen können. Was folgte, war jahrelange Arbeit, die den Formfaktor optimierte. Ein rundes Objekt würde nicht funktionieren; Der Benutzer konnte nicht sagen, wie es ausgerichtet war. Es musste groß genug sein, um es zu kontrollieren, aber klein genug, um sich in der Wange zu verstecken. Gallego machte ChewIt zusammen mit seinem Forschungskollegen Denys Matthies aus einem asymmetrischen Polymerharzklecks, der eine Leiterplatte mit einem Knopf enthielt, mit dem ein Stuhl gesteuert und bewegt werden kann.

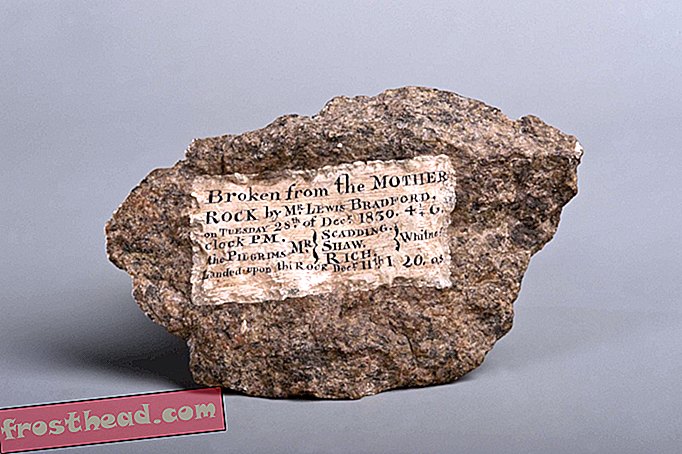

Dieser Prototyp von ChewIt zeigt das Polymerharz und die Leiterplatte. (Universität von Auckland)

Dieser Prototyp von ChewIt zeigt das Polymerharz und die Leiterplatte. (Universität von Auckland) Gallego und Matthies konzipierten und bauten ChewIt im Augmented Human Lab der Universität Auckland, einer Forschungsgruppe, die Ingenieurprofessor Suranga Nanayakkara zusammenstellte, um Werkzeuge zu erfinden, mit denen Technologien für den menschlichen Gebrauch angepasst werden können, anstatt umgekehrt. Laut Nanayakkara gibt es ein Missverhältnis zwischen dem, was unsere Technologie leistet, und der Art und Weise, wie sie mit uns kommuniziert. Wir sollten es nicht lernen müssen; es sollte uns lernen.

"Leistungsstarke Technologie, die schlecht designt ist, lässt Benutzer sich behindert fühlen", sagt Nanayakkara. „Eine leistungsstarke Technologie mit der richtigen Mensch-Maschine-Schnittstelle gibt den Menschen das Gefühl, gestärkt zu sein. Dadurch rückt die Interaktion von Mensch zu Mensch in den Vordergrund und die Technologie bleibt im Hintergrund. Es hilft, das volle Potenzial der Technologie auszuschöpfen. “

Nanayakkara hat alles getan, um sicherzustellen, dass Studenten und Wissenschaftler in seinem produktiven Labor in die Lage versetzt werden, auf der Grundlage ihrer Interessen zu arbeiten und bei ihren Ideen zusammenzuarbeiten. Die Vielfalt der von ihnen entwickelten Technologien ist bemerkenswert. Es gibt eine Begrüßungsmatte, die die Bewohner anhand ihres Fußabdrucks erkennt, einschließlich des Gewichts des Trägers und der Abnutzungsprofile der Sohlen, und die Tür für sie aufschließt. Es gibt einen persönlichen Gedächtnistrainer, der sich über Audio einlässt, wenn er erkennt, dass der Benutzer Zeit und Aufmerksamkeit zum Üben hat. Es gibt einen intelligenten Cricketschläger, mit dem Benutzer den Griff und das Schwingen üben können. Es gibt einen Schrittdetektor für Gehhilfen für ältere Menschen, da die FitBits und Smartwatches häufig Schritte falsch zählen, wenn Menschen Rollen benutzen.

Und es gibt GymSoles. Diese intelligenten Einlegesohlen wirken wie ein Gewichtheber und helfen den Trägern, während Kniebeugen und Kreuzheben die richtige Form und Haltung beizubehalten. "Diese haben sehr unterschiedliche Haltungen", sagt Samitha Elvitigala, die das Gerät im Rahmen seiner Doktorandenbewerbung baut. „Es gibt einige subtile Bewegungen, denen Sie folgen müssen, sonst werden Sie verletzt.“ Sensoren in den Sohlen verfolgen das Druckprofil der Füße, berechnen den Druckmittelpunkt und vergleichen es mit dem Muster, das es sein sollte - Sagen Sie, ob der Gewichtheber zu weit nach hinten oder zu weit nach vorne geneigt ist. Anschließend gibt das Gerät eine haptische Rückmeldung in Form subtiler Vibrationen, die angibt, wie sich der Lifter ausrichten soll. Durch die richtige Einstellung der Neigung und Positionierung von Füßen, Beinen und Hüften fällt der gesamte Körper in die richtige Form. Elvitigala verfeinert das Projekt noch und prüft, wie es für andere Anwendungen eingesetzt werden kann, beispielsweise zur Verbesserung des Gleichgewichts bei Parkinson-Patienten oder Schlaganfallopfern.

Der Ursprung des Augmented Human Labs geht zurück auf eine Erfahrung, die Nanayakkara in der High School gemacht hat. Er arbeitete mit Schülern einer Wohnheimschule für Gehörlose zusammen und stellte fest, dass alle außer ihm nahtlos miteinander kommunizierten. Es brachte ihn dazu, Kommunikation und Fähigkeiten zu überdenken. "Es geht nicht immer darum, Behinderungen zu beheben, sondern sich mit Menschen zu verbinden", sagt er. "Ich hatte das Gefühl, dass ich etwas brauchte, um mit ihnen in Verbindung zu treten." Später bemerkte er ein ähnliches Problem bei der Kommunikation mit Computern.

Während seines Studiums der Ingenieurwissenschaften und anschließend als Postdoc in der Fluid Interfaces-Gruppe der Informatikerin Pattie Maes vom MIT Media Lab lernte er, darüber nachzudenken. Wie das Augmented Human Lab baut die Fluid Interfaces-Gruppe Geräte, die die kognitiven Fähigkeiten über nahtlose Computerschnittstellen verbessern sollen.

„Geräte spielen in unserem Leben eine Rolle, und im Moment wirken sie sich sehr negativ auf unser körperliches und soziales Wohlbefinden aus“, sagt Maes. "Wir müssen Wege finden, um Geräte besser in unser physisches und soziales Leben zu integrieren, damit sie weniger störend wirken und weniger negative Auswirkungen haben."

Das Ziel, sagt Maes, ist nicht, Computer dazu zu bringen, alles für uns zu tun. Wir werden besser dran sein, wenn sie uns beibringen können, die Dinge selbst besser zu machen und uns dabei zu helfen. Zum Beispiel entwarfen ihre Schüler eine Brille, die die Augenbewegungen und das EEG der Träger aufzeichnet und sie daran erinnert, sich auf einen Vortrag oder eine Lesung zu konzentrieren, wenn ihre Aufmerksamkeit nachlässt. Ein anderer nutzt Augmented Reality, um Benutzern zu helfen, beim Gehen Erinnerungen auf Straßen abzubilden. Diese Technik wird von Memory Champions als „Memory Palace“ bezeichnet. Vergleichen Sie das mit Google (vielleicht suchen Sie nach „Halloween-Kostümen“, anstatt kreativ zu werden, sagt Maes ) oder Google Maps, die unser Bedürfnis, Informationen zu speichern oder zu verstehen, wo wir uns befinden, weitgehend ersetzt haben.

„Wir vergessen oft, dass wenn wir einen solchen Service nutzen, der uns steigert, immer Kosten entstehen“, sagt sie. „Viele der Geräte und Systeme, die wir bauen, erweitern eine Person mit bestimmten Funktionen. Aber wann immer Sie eine Aufgabe oder Fähigkeit erweitern, verlieren Sie manchmal auch ein bisschen von dieser Fähigkeit. “

Das vielleicht bekannteste Gerät von Nanayakkara, der FingerReader, begann zu seiner Zeit am MIT. FingerReader wurde für Sehbehinderte entwickelt und verfügt über eine einfache Benutzeroberfläche: Richten Sie die Ringkamera auf etwas, klicken Sie darauf, und das Gerät zeigt über einen Kopfhörer an, was es ist, oder liest den darauf befindlichen Text.

FingerReader folgte Nanayakkara nach Singapur, wo er zuerst das Augmented Human Lab an der Singapore University of Technology and Design startete, und dann an die University of Auckland, wo er sein 15-köpfiges Team im März 2018 verlegte Studenten haben FingerReader verfeinert und nachfolgende Versionen erstellt. Wie viele andere Geräte ist auch der FingerReader (vorläufig) patentiert und könnte eines Tages auf den Markt kommen. (Nanayakkara gründete ein Startup namens ZuZu Labs, um das Gerät zu produzieren. Derzeit wird ein Testlauf von einigen hundert Exemplaren durchgeführt.)

In gewisser Weise löst die Erweiterung virtueller Assistenten wie Siri, Alexa und Google Assistant ähnliche Probleme. Sie ermöglichen eine natürlichere Schnittstelle, eine natürlichere Kommunikation zwischen Menschen und ihren allgegenwärtigen Computern. Nanayakkara verzichtet jedoch nicht auf seine Geräte, sondern bietet lediglich ein neues Werkzeug an, um sie zu ergänzen.

"Diese Technologie ist großartig, sie muss passieren, so schreitet das Feld voran", sagt er. „Aber irgendjemand muss sich überlegen, wie er die volle Kraft dieser Menschen am besten nutzen kann. Wie kann ich das nutzen, um die nächste aufregende Mensch-Maschine-Interaktion zu schaffen? “

* Anmerkung des Herausgebers, 15. April 2019: In einer früheren Version dieses Artikels wurde fälschlicherweise angegeben, dass Suranga Nanayakkara sein Team im Mai 2018 von der Singapore University of Technology and Design an die University of Auckland verlegt hatte , obwohl es im März 2018 war. Die Geschichte wurde bearbeitet, um diese Tatsache zu korrigieren.