Wie der Gedenktag uns jedes Jahr erinnert, verschwindet der Krieg nicht.

Aber es ändert sich. Und eine der tiefgreifenderen Veränderungen, die wir in den kommenden Jahren sehen werden, ist ein Militär, das zunehmend von Robotern abhängig ist. Drohnen bekommen jetzt die meiste Aufmerksamkeit, aber immer mehr Innovationen des Verteidigungsministeriums sind andere Arten von unbemannten Maschinen, von Versuchsflugzeugen bis zu Soldaten am Boden.

Die Anziehungskraft ist leicht zu verstehen. Der Einsatz von Robotern ist potenziell effizienter, präziser und kostengünstiger als die alleinige Abhängigkeit von Menschen in der Kriegsführung. Und es würde natürlich auch weniger Menschenleben bedeuten.

Diese Transformation bringt jedoch eine komplexe Herausforderung mit sich: Können militärische Maschinen so programmiert werden, dass sie Entscheidungen treffen? Was zu einer heiklen Frage führt: Können Roboter Moral lernen?

Das US Office of Naval Research ist der Ansicht, dass es jetzt an der Zeit ist, dies herauszufinden. Anfang dieses Monats wurde ein Fünfjahreszuschuss in Höhe von 7, 5 Mio. USD zur Finanzierung der Forschung an den Universitäten Tufts, Brown, Yale und Georgetown sowie am Rensselaer Polytechnic Institute (RPI) angekündigt, ob Maschinen eines Tages in der Lage sein werden, zwischen Richtigen und Falschen zu wählen.

Die Marine will die Situation vermeiden, in der Googles fahrerloses Auto jetzt zu sehen ist: eine Technologie, die weit vor jeglicher Klarheit über die rechtlichen und ethischen Probleme, die damit verbunden sind, veröffentlicht wurde. Bevor autonome Roboter ins Feld gehen, will das Militär wissen, ob sie tatsächlich lernen können, das Richtige zu tun.

Wie Selmer Bringsjord, Leiter der Abteilung Kognitionswissenschaft des RPI, sieht, könnte die künstliche Intelligenz eines Roboters so ausgelegt sein, dass sie auf zwei Ebenen der Moral funktioniert. Die erste basiert auf einer Checkliste klarer ethischer Entscheidungen, z. B. „Wenn Sie auf einen verwundeten Soldaten stoßen, sollten Sie ihm oder ihr helfen.“ Was aber, wenn diese Aktion im Widerspruch zu seiner Hauptaufgabe steht, z andere Soldaten? Zu diesem Zeitpunkt, so Bringsjord, müsste der Roboter in der Lage sein, sich auf „tiefere moralische Überlegungen“ einzulassen, um Entscheidungen in Situationen zu treffen, die seine Programmierer möglicherweise nicht vorhersehen konnten.

Die Forscher müssten einzigartige Algorithmen und Berechnungsmechanismen entwickeln, die in die vorhandene Architektur autonomer Roboter integriert werden könnten. Dieser "Denkprozess" würde es einer Maschine ermöglichen, geplantes Verhalten aufgrund ihrer Fähigkeit, moralisches Denken anzuwenden, außer Kraft zu setzen.

Wenn dies außerordentlich ehrgeizig erscheint, ist es das auch. Zunächst müssen die Forscher die grundlegenden Elemente der menschlichen Moral isolieren - über welche Prinzipien sind wir uns alle einig? - und dann herausfinden, wie sie in Algorithmen integriert werden können, die Robotern ein gewisses Maß an moralischer Kompetenz verleihen.

Das ist kein kleines Unterfangen. Aus diesem Grund ist es wahrscheinlich, dass Maschinen, die nicht von Menschen gesteuert werden, in absehbarer Zeit auf nicht kämpfende Funktionen wie Überwachung, Sicherheit, Suche und Rettung oder medizinische Versorgung beschränkt sind. Aber die Militärplaner werden sich unweigerlich eine Antwort auf die Frage wünschen, die all dies betrifft: Sollten Roboter, die alleine handeln, jemals einen Menschen töten dürfen?

Wenn eine Maschine zu 90 Prozent sicher ist, dass jeder in einem Fahrzeug, auf das sie schießen will, ein Terrorist ist, ist das sicher genug? Wäre ein Roboter in der Lage, eine Waffe auf ein Kind abzufeuern, wenn er feststellt, dass es sich um den Feind handelt? Wenn etwas schief geht und ein autonomer Roboter versehentlich ein Dorf in die Luft jagt, wer ist dafür verantwortlich? Der Kommandant, der die Operation befohlen hat? Die Person, die den Roboter programmiert hat? Oder niemand?

Wenn Sie der Meinung sind, dass dies immer noch Science-Fiction ist, haben sich Anfang dieses Monats Experten für Themen wie künstliche Intelligenz, Menschenrechte und internationales Recht auf einer Konferenz der Vereinten Nationen in Genf mit „Killerrobotern“ befasst. Gruppen wie Human Rights Watch und Beamte aus einigen Ländern, darunter Pakistan, Ägypten, Kuba und der Vatikan, forderten ein völliges Verbot von Robotern mit Tötungsbefugnis. Aber die meisten Länder, insbesondere diejenigen mit den fortschrittlichsten Robotern, sind nicht bereit, so weit zu gehen.

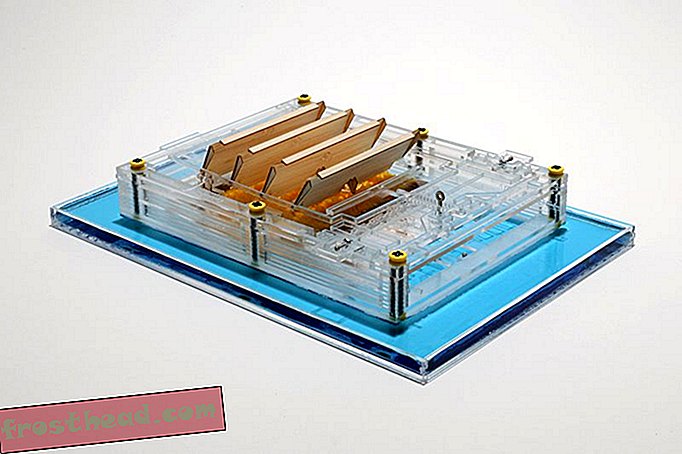

Schauen Sie sich zum Beispiel den WildCat an, einen vierbeinigen Roboter, der für hohe Geschwindigkeiten in jedem Gelände entwickelt wurde.

Derzeit befolgt das US-Militär die Richtlinie des Verteidigungsministeriums von 2012, wonach keine Maschine mit der Befugnis zum Töten völlig autonom sein kann. Ein Mensch muss buchstäblich das Sagen haben. Aber das mag nicht an allen Orten zutreffen: Im März zitierte New Scientist einen russischen Beamten, wonach Roboter-Wachposten an fünf Einrichtungen für ballistische Raketen in der Lage sein werden, Ziele zu erkennen und zu zerstören, ohne dass ein Mensch den Startschuss gibt.

Die Foster-Miller-Klaue (siehe unten) ist eine der vielen Maschinen auf der ganzen Welt, die für den Kampf entwickelt wurden.

Kriegsregeln

Ein Bericht über die Killerroboterkonferenz wird im November dem Komitee für bestimmte Coventional-Waffen der Vereinten Nationen vorgelegt. Es scheint aber nicht, dass bald ein Verbot kommt.

An der Diskussion in Genf nahm unter anderem Ronald Arkin teil, ein Experte für künstliche Intelligenz von Georgia Tech, der sich seit langem dafür einsetzt, dass Maschinen moralische Entscheidungen treffen können. Er glaubt, wenn Roboter lernen können, das Völkerrecht zu befolgen, könnten sie sich in der Kriegsführung tatsächlich ethischer verhalten als Menschen, weil sie unfehlbar konsequent wären. Sie würden nicht in der Lage sein, in Wut oder mit Panik oder Vorurteilen zu antworten. Also lehnt Arkin ein Verbot ab, obwohl er für ein Moratorium für autonome Waffen offen ist, bis Maschinen die Chance erhalten, zu sehen, ob sie die Regeln des Krieges beherrschen.

Ein anderer KI-Wissenschaftler, Noel Sharkey, der in Genf über Arkin debattierte, ist anderer Meinung. Er glaubt nicht, dass Roboter jemals die Befugnis erhalten sollten, Entscheidungen über Leben oder Tod zu treffen.

Kürzlich sagte er zu Defense One : „Ich glaube nicht, dass sie jemals mit einem moralischen oder ethischen Roboter enden werden. Dafür brauchen wir moralische Entscheidungsfreiheit. Dafür müssen wir andere verstehen und wissen, was es bedeutet, zu leiden. "

"Ein Roboter kann nach bestimmten ethischen Grundsätzen installiert werden, aber das ist ihm eigentlich egal", sagt er.