Jeder hat von den neuen Fortschritten bei der künstlichen Intelligenz und insbesondere beim maschinellen Lernen gehört. Sie haben auch utopische oder apokalyptische Vorhersagen darüber gehört, was diese Fortschritte bedeuten. Sie wurden als Vorboten der Unsterblichkeit oder des Endes der Welt angesehen, und es wurde viel über beide Möglichkeiten geschrieben. Die anspruchsvollsten KIs sind jedoch noch lange nicht in der Lage, Probleme zu lösen, die menschliche Vierjährige mühelos lösen können. Trotz des eindrucksvollen Namens besteht künstliche Intelligenz hauptsächlich aus Techniken zur Erkennung statistischer Muster in großen Datenmengen. Das menschliche Lernen beinhaltet viel mehr.

Wie können wir möglicherweise so viel über die Welt um uns herum wissen? Wir lernen eine enorme Menge, auch wenn wir kleine Kinder sind; Vierjährige kennen sich bereits mit Pflanzen, Tieren und Maschinen aus; Wünsche, Überzeugungen und Emotionen; sogar Dinosaurier und Raumschiffe.

Die Wissenschaft hat unser Wissen über die Welt auf das unvorstellbar Große und das unendlich Kleine, auf den Rand des Universums und den Beginn der Zeit ausgedehnt. Und wir nutzen dieses Wissen, um neue Klassifikationen und Vorhersagen zu treffen, uns neue Möglichkeiten vorzustellen und neue Dinge in der Welt geschehen zu lassen. Aber alles, was uns von der Welt aus erreicht, ist ein Photonenstrom, der auf unsere Netzhaut trifft, und Luftstörungen am Trommelfell. Wie können wir so viel über die Welt lernen, wenn die verfügbaren Beweise so begrenzt sind? Und wie machen wir das alles mit ein paar Kilo grauer Gänsehaut, die sich hinter unseren Augen befindet?

Die bisher beste Antwort ist, dass unser Gehirn Berechnungen an den konkreten, unsauberen Daten vornimmt, die zu unseren Sinnen gelangen, und diese Berechnungen genaue Darstellungen der Welt liefern. Die Darstellungen scheinen strukturiert, abstrakt und hierarchisch zu sein. Dazu gehören die Wahrnehmung dreidimensionaler Objekte, die der Sprache zugrunde liegenden Grammatiken und mentale Fähigkeiten wie „Theory of Mind“, mit denen wir verstehen, was andere Menschen denken. Diese Darstellungen ermöglichen es uns, eine breite Palette neuer Vorhersagen zu treffen und uns viele neue Möglichkeiten auf eine ausgesprochen kreative menschliche Art vorzustellen.

Diese Art des Lernens ist nicht die einzige Art von Intelligenz, aber für den Menschen besonders wichtig. Und es ist die Art von Intelligenz, die eine Spezialität von kleinen Kindern ist. Obwohl Kinder bei der Planung und Entscheidungsfindung dramatisch schlecht sind, sind sie die besten Lerner im Universum. Ein Großteil des Prozesses, Daten in Theorien umzuwandeln, findet statt, bevor wir fünf sind.

Seit Aristoteles und Platon gibt es zwei grundlegende Methoden, um das Problem zu lösen, wie wir wissen, was wir wissen, und sie sind immer noch die Hauptansätze beim maschinellen Lernen. Aristoteles ging das Problem von unten nach oben an: Beginnen Sie mit den Sinnen - dem Strom von Photonen und Luftschwingungen (oder den Pixeln oder Tonbeispielen eines digitalen Bildes oder einer digitalen Aufnahme) - und prüfen Sie, ob Sie daraus Muster extrahieren können. Dieser Ansatz wurde von klassischen Assoziatoren wie den Philosophen David Hume und JS Mill und später von Verhaltenspsychologen wie Pavlov und BF Skinner weitergeführt. Aus dieser Sicht ist die Abstraktheit und hierarchische Struktur von Darstellungen eine Illusion oder zumindest ein Epiphänomen. Die ganze Arbeit kann durch Assoziations- und Mustererkennung erledigt werden - insbesondere, wenn genügend Daten vorhanden sind.

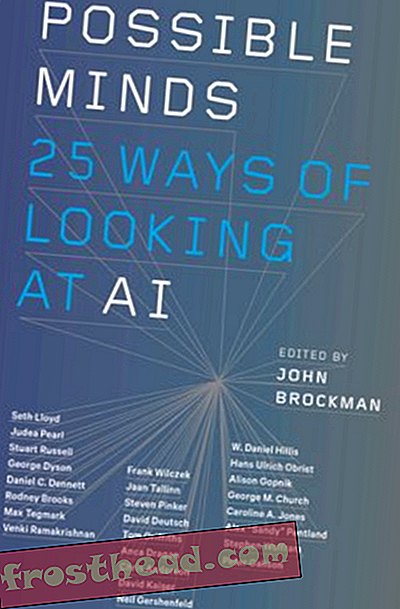

Mögliche Gedanken: 25 Möglichkeiten, AI zu betrachten

John Brockman, der Star der Wissenschaftswelt, versammelt 25 der wichtigsten wissenschaftlichen Köpfe, die sich die meiste Zeit ihrer Karriere mit künstlicher Intelligenz befasst haben, zu einer beispiellosen Diskussionsrunde über Geist, Denken, Intelligenz und was dies bedeutet menschlich sein.

KaufenIm Laufe der Zeit gab es eine Wippe zwischen dieser Bottom-Up-Herangehensweise an das Mysterium des Lernens und Platons alternativer Top-Down-Herangehensweise. Vielleicht erhalten wir abstraktes Wissen aus konkreten Daten, weil wir bereits viel wissen und vor allem, weil wir dank der Evolution bereits eine Reihe grundlegender abstrakter Konzepte haben. Wie Wissenschaftler können wir diese Konzepte verwenden, um Hypothesen über die Welt zu formulieren. Anstatt dann zu versuchen, Muster aus den Rohdaten zu extrahieren, können wir Vorhersagen darüber treffen, wie die Daten aussehen sollten, wenn diese Hypothesen richtig sind. Zusammen mit Platon verfolgten solche "rationalistischen" Philosophen und Psychologen wie Descartes und Noam Chomsky diesen Ansatz.

Hier ist ein alltägliches Beispiel, das den Unterschied zwischen den beiden Methoden veranschaulicht: Lösen der Spam-Plage. Die Daten bestehen aus einer langen, unsortierten Liste von Nachrichten in Ihrem Posteingang. Die Realität ist, dass einige dieser Nachrichten echt und andere Spam sind. Wie können Sie die Daten verwenden, um zwischen ihnen zu unterscheiden?

Betrachten Sie zuerst die Bottom-up-Technik. Sie stellen fest, dass die Spam-Nachrichten in der Regel bestimmte Merkmale aufweisen: eine lange Liste von Adressaten, Herkunft in Nigeria, Verweise auf Millionenpreise oder Viagra. Das Problem ist, dass auch sehr nützliche Nachrichten über diese Funktionen verfügen können. Wenn Sie sich genügend Beispiele für Spam- und Nicht-Spam-E-Mails ansehen, werden Sie möglicherweise nicht nur feststellen, dass Spam-E-Mails in der Regel über diese Funktionen verfügen, sondern auch, dass diese Funktionen in besonderer Weise zusammenpassen (Nigeria plus eine Million Dollar Zauberprobleme). Tatsächlich kann es einige subtile Korrelationen auf höherer Ebene geben, die die Spam-Nachrichten von den nützlichen unterscheiden - beispielsweise ein bestimmtes Muster von Rechtschreibfehlern und IP-Adressen. Wenn Sie diese Muster erkennen, können Sie den Spam herausfiltern.

Die Bottom-Up-Techniken des maschinellen Lernens tun genau dies. Der Lernende erhält Millionen von Beispielen, von denen jedes eine Reihe von Funktionen aufweist und als Spam (oder eine andere Kategorie) gekennzeichnet ist oder nicht. Der Computer kann das Muster der Merkmale extrahieren, die die beiden unterscheiden, auch wenn es recht subtil ist.

Wie wäre es mit dem Top-Down-Ansatz? Ich erhalte eine E-Mail vom Herausgeber des Journal of Clinical Biology . Es bezieht sich auf eine meiner Arbeiten und sagt, dass sie einen Artikel von mir veröffentlichen möchten. Kein Nigeria, kein Viagra, keine Millionen Dollar; Die E-Mail hat keine der Funktionen von Spam. Wenn ich jedoch das, was ich bereits weiß, verwende und abstrakt über den Prozess nachdenke, der Spam erzeugt, kann ich feststellen, dass diese E-Mail verdächtig ist:

1. Ich weiß, dass Spammer versuchen, Geld aus Menschen herauszuholen, indem sie die menschliche Gier ansprechen.

2. Ich weiß auch, dass legitime „Open Access“ -Zeitschriften angefangen haben, ihre Kosten zu decken, indem sie Autoren statt Abonnenten in Rechnung stellten, und dass ich nichts Ähnliches wie klinische Biologie praktiziere.

Wenn Sie das alles zusammenfassen, kann ich eine gute neue Hypothese darüber aufstellen, woher diese E-Mail stammt. Es soll Akademiker dazu bringen, dafür zu zahlen, dass sie einen Artikel in einem gefälschten Journal „veröffentlichen“. Die E-Mail war das Ergebnis desselben zweifelhaften Prozesses wie die anderen Spam-E-Mails, obwohl sie nicht so aussah wie sie. Ich kann diese Schlussfolgerung aus nur einem Beispiel ziehen und meine Hypothese über alles in der E-Mail hinaus weiter testen, indem ich den „Editor“ google.

In Bezug auf Computer begann ich mit einem „generativen Modell“, das abstrakte Konzepte wie Gier und Täuschung enthält und den Prozess beschreibt, der E-Mail-Betrug erzeugt. Dadurch kann ich den klassischen nigerianischen E-Mail-Spam erkennen, mir aber auch viele verschiedene Arten von möglichem Spam vorstellen. Wenn ich die Journal-E-Mail erhalte, kann ich rückwärts arbeiten: "Dies scheint nur die Art von E-Mail zu sein, die aus einem Spam-generierenden Prozess resultieren würde."

Die neue Aufregung über KI kommt daher, dass KI-Forscher kürzlich leistungsstarke und effektive Versionen dieser beiden Lernmethoden entwickelt haben. Aber an den Methoden selbst ist nichts zutiefst Neues.

Bottom-up Deep Learning

In den 1980er Jahren entwickelten Computerwissenschaftler eine ausgeklügelte Methode, um Computer dazu zu bringen, Muster in Daten zu erkennen: verbindungsorientierte oder neuronale Netzwerkarchitektur (der „neuronale“ Teil war und ist metaphorisch). Der Ansatz geriet in den 1990er Jahren in eine Flaute, wurde jedoch kürzlich mit leistungsstarken Deep-Learning-Methoden wie DeepMind von Google wiederbelebt.

Beispielsweise können Sie einem Deep-Learning-Programm eine Reihe von Internetbildern mit der Bezeichnung "cat", andere mit der Bezeichnung "house" usw. geben. Das Programm kann die Muster erkennen, die die beiden Bildsätze unterscheiden, und diese Informationen verwenden, um neue Bilder korrekt zu kennzeichnen. Einige Arten des maschinellen Lernens, das als unbeaufsichtigtes Lernen bezeichnet wird, können Muster in Daten erkennen, die überhaupt keine Bezeichnungen haben. sie suchen einfach nach Merkmalsclustern - was Wissenschaftler eine Faktorenanalyse nennen. In den Deep-Learning-Maschinen wiederholen sich diese Prozesse auf verschiedenen Ebenen. Einige Programme können sogar relevante Funktionen aus den Rohdaten von Pixeln oder Sounds ermitteln. Der Computer erkennt zunächst möglicherweise die Muster im Rohbild, die Kanten und Linien entsprechen, und findet dann die Muster in den Mustern, die Flächen entsprechen, und so weiter.

Eine andere Bottom-up-Technik mit einer langen Geschichte ist das Lernen der Bestärkung. In den 1950er Jahren programmierte BF Skinner auf der Grundlage der Arbeit von John Watson Tauben so, dass sie aufwändige Aktionen ausführen und sogar vom Flugzeug abgefeuerte Raketen zu ihren Zielen führen konnten (ein störendes Echo der jüngsten KI), indem sie ihnen einen bestimmten Zeitplan für Belohnungen und Bestrafungen gaben . Die Grundidee war, dass belohnte Handlungen wiederholt und bestraft werden, bis das gewünschte Verhalten erreicht ist. Selbst zu Skinners Zeiten könnte dieser einfache Vorgang, der immer wieder wiederholt wird, zu komplexem Verhalten führen. Computer sind so konzipiert, dass sie einfache Vorgänge immer wieder in einem Ausmaß ausführen, das die Vorstellungskraft des Menschen in den Schatten stellt, und Computersysteme können auf diese Weise bemerkenswert komplexe Fähigkeiten erlernen.

Beispielsweise verwendeten Forscher von Googles DeepMind eine Kombination aus vertieftem Lernen und vertieftem Lernen, um einem Computer das Spielen von Atari-Videospielen beizubringen. Der Computer wusste nichts darüber, wie die Spiele funktionierten. Zunächst handelte es sich um einen Zufallsgenerator, der nur darüber informierte, wie der Bildschirm in jedem Moment aussah und wie gut er abgeschnitten hatte. Deep Learning half dabei, die Funktionen auf dem Bildschirm zu interpretieren, und das Erlernen von Verstärkung belohnte das System mit höheren Punktzahlen. Der Computer konnte einige der Spiele sehr gut spielen, aber er bombardierte auch andere, die für Menschen genauso einfach zu meistern waren.

Eine ähnliche Kombination aus vertieftem Lernen und vertieftem Lernen hat den Erfolg von DeepMinds AlphaZero ermöglicht, einem Programm, das es geschafft hat, menschliche Spieler sowohl beim Schach als auch beim Go zu schlagen, und das nur über Grundkenntnisse der Spielregeln und einige Planungsfähigkeiten verfügt. AlphaZero hat ein weiteres interessantes Feature: Es funktioniert, indem es Hunderte von Millionen von Spielen gegen sich selbst spielt. Dabei werden Fehler, die zu Verlusten geführt haben, beschnitten und Strategien, die zu Gewinnen geführt haben, wiederholt und ausgearbeitet. Solche Systeme und andere Techniken, die als generative kontradiktorische Netzwerke bezeichnet werden, erzeugen Daten und beobachten Daten.

Wenn Sie über die Rechenleistung verfügen, diese Techniken auf sehr große Datenmengen oder Millionen von E-Mail-Nachrichten, Instagram-Bildern oder Sprachaufzeichnungen anzuwenden, können Sie Probleme lösen, die zuvor sehr schwierig erschienen. Das ist der Grund für die Aufregung in der Informatik. Aber es lohnt sich, sich daran zu erinnern, dass diese Probleme - wie das Erkennen, dass ein Bild eine Katze ist oder ein gesprochenes Wort Siri - für ein menschliches Kleinkind trivial sind. Eine der interessantesten Entdeckungen der Informatik ist, dass Probleme, die für uns einfach sind (wie das Identifizieren von Katzen), für Computer schwierig sind - viel schwieriger als Schach oder Go. Computer benötigen Millionen von Beispielen, um Objekte zu kategorisieren, die wir mit nur wenigen kategorisieren können. Diese Bottom-up-Systeme können auf neue Beispiele verallgemeinert werden. Sie können ein neues Bild als Katze ziemlich genau bezeichnen. Aber sie tun dies auf ganz andere Weise als die Menschen. Einige Bilder, die fast mit einem Katzenbild identisch sind, werden von uns überhaupt nicht als Katzen identifiziert. Andere, die wie eine zufällige Unschärfe aussehen, werden es sein.

Top-Down Bayesianische Modelle

Der Top-Down-Ansatz spielte in der frühen KI eine große Rolle und erlebte auch in den 2000er Jahren eine Wiederbelebung in Form probabilistischer oder bayesianischer generativer Modelle.

Bei den ersten Versuchen, diesen Ansatz zu verwenden, traten zwei Arten von Problemen auf. Erstens könnten die meisten Beweismuster im Prinzip durch viele verschiedene Hypothesen erklärt werden: Es ist möglich, dass meine Journal-E-Mail-Nachricht echt ist, es scheint nur unwahrscheinlich. Zweitens, woher kommen die Konzepte, die die generativen Modelle verwenden? Platon und Chomsky sagten, dass Sie mit ihnen geboren wurden. Aber wie können wir erklären, wie wir die neuesten Konzepte der Wissenschaft lernen? Oder wie verstehen schon kleine Kinder von Dinosauriern und Raketenschiffen?

Bayesianische Modelle kombinieren generative Modelle und Hypothesentests mit der Wahrscheinlichkeitstheorie und adressieren diese beiden Probleme. Mit einem Bayes'schen Modell können Sie anhand der Daten berechnen, wie wahrscheinlich es ist, dass eine bestimmte Hypothese zutrifft. Und indem wir kleine, aber systematische Änderungen an den bereits vorhandenen Modellen vornehmen und diese anhand der Daten testen, können wir manchmal neue Konzepte und Modelle aus alten erstellen. Diesen Vorteilen stehen jedoch andere Probleme gegenüber. Die Bayes'schen Techniken können Ihnen dabei helfen, die wahrscheinlichste der beiden Hypothesen auszuwählen, aber es gibt fast immer eine enorme Anzahl möglicher Hypothesen, und kein System kann sie alle effizient berücksichtigen. Wie entscheiden Sie, welche Hypothesen es überhaupt zu prüfen gilt?

Brenden Lake an der New York University und Kollegen haben diese Art von Top-Down-Methoden verwendet, um ein weiteres Problem zu lösen, das für Menschen einfach, für Computer jedoch äußerst schwierig ist: das Erkennen unbekannter handgeschriebener Zeichen. Betrachte ein Zeichen auf einer japanischen Schriftrolle. Selbst wenn Sie es noch nie zuvor gesehen haben, können Sie wahrscheinlich feststellen, ob es einem Zeichen auf einer anderen japanischen Schriftrolle ähnelt oder sich von diesem unterscheidet. Sie können es wahrscheinlich zeichnen und sogar ein falsches japanisches Zeichen entwerfen, das auf dem angezeigten basiert - eines, das sich von einem koreanischen oder russischen Zeichen deutlich unterscheidet.

Die Bottom-up-Methode zum Erkennen handgeschriebener Zeichen besteht darin, dem Computer Tausende von Beispielen zu geben und die hervorstechenden Merkmale hervorzuheben. Stattdessen haben Lake et al. gab dem Programm ein allgemeines Modell, wie Sie einen Charakter zeichnen: Ein Strich geht entweder nach rechts oder nach links; Nachdem Sie einen beendet haben, starten Sie einen anderen. und so weiter. Wenn das Programm ein bestimmtes Zeichen sah, konnte es auf die Abfolge der Striche schließen, die wahrscheinlich dazu geführt haben - genau wie ich schlussfolgerte, dass der Spam-Prozess zu meiner zweifelhaften E-Mail führte. Dann könnte es beurteilen, ob ein neues Zeichen wahrscheinlich aus dieser Sequenz oder aus einer anderen resultiert, und es könnte selbst einen ähnlichen Satz von Strichen erzeugen. Das Programm funktionierte viel besser als ein Deep-Learning-Programm, das auf genau dieselben Daten angewendet wurde, und spiegelte die Leistung des Menschen sehr gut wider.

Diese beiden Ansätze des maschinellen Lernens weisen komplementäre Stärken und Schwächen auf. Beim Bottom-up-Ansatz benötigt das Programm zunächst nicht viel Wissen, benötigt jedoch viele Daten und kann nur begrenzt verallgemeinern. Beim Top-Down-Ansatz kann das Programm aus nur wenigen Beispielen lernen und viel umfassendere und vielfältigere Verallgemeinerungen vornehmen. Zunächst müssen Sie jedoch noch viel mehr in das Programm einbauen. Eine Reihe von Forschern versucht derzeit, die beiden Ansätze zu kombinieren, indem sie Deep Learning nutzen, um Bayes'sche Inferenz zu implementieren.

Der jüngste Erfolg von AI ist zum Teil auf die Erweiterung dieser alten Ideen zurückzuführen. Es hat jedoch mehr damit zu tun, dass wir dank des Internets viel mehr Daten haben und dass wir dank Moores Gesetz viel mehr Rechenkraft haben, um diese Daten anzuwenden. Darüber hinaus ist es eine nicht zu unterschätzende Tatsache, dass die Daten, die wir haben, bereits von Menschen sortiert und verarbeitet wurden. Die im Web veröffentlichten Katzenbilder sind kanonische Katzenbilder - Bilder, die Menschen bereits als „gute“ Bilder ausgewählt haben. Google Translate funktioniert, weil es Millionen menschlicher Übersetzungen nutzt und sie zu einem neuen Textstück verallgemeinert, anstatt die Sätze selbst wirklich zu verstehen.

Aber das wirklich Bemerkenswerte an menschlichen Kindern ist, dass sie irgendwie die besten Eigenschaften jedes Ansatzes kombinieren und dann weit über sie hinausgehen. In den letzten fünfzehn Jahren haben Entwicklungsforscher untersucht, wie Kinder aus Daten Struktur lernen. Vierjährige können lernen, indem sie nur ein oder zwei Datenbeispiele verwenden, wie es ein Top-Down-System tut, und auf sehr unterschiedliche Konzepte verallgemeinern. Sie können aber auch neue Konzepte und Modelle aus den Daten selbst lernen, wie dies bei einem Bottom-up-System der Fall ist.

Zum Beispiel geben wir in unserem Labor kleinen Kindern einen „Blicket-Detektor“ - eine neue Maschine, die sie noch nie gesehen haben. Es ist eine Box, die aufleuchtet und Musik abspielt, wenn Sie bestimmte Objekte darauf ablegen, andere jedoch nicht. Wir geben den Kindern nur ein oder zwei Beispiele, wie die Maschine funktioniert, und zeigen ihnen, dass beispielsweise zwei rote Blöcke sie bewegen, während eine Grün-Gelb-Kombination dies nicht tut. Sogar Achtzehnmonatige erkennen sofort das allgemeine Prinzip, dass die beiden Objekte gleich sein müssen, um zu funktionieren, und sie verallgemeinern dieses Prinzip auf neue Beispiele: Zum Beispiel werden sie zwei Objekte auswählen, die die gleiche Form haben die maschinenarbeit. In anderen Experimenten haben wir gezeigt, dass Kinder sogar herausfinden können, dass eine verborgene unsichtbare Eigenschaft die Maschine zum Laufen bringt oder dass die Maschine nach einem abstrakten logischen Prinzip arbeitet.

Sie können dies auch im alltäglichen Lernen der Kinder zeigen. Kleine Kinder lernen sehr schnell abstrakte intuitive Theorien der Biologie, Physik und Psychologie, so wie es erwachsene Wissenschaftler tun, selbst mit relativ wenigen Daten.

Die bemerkenswerten maschinellen Lernleistungen der jüngsten KI-Systeme, sowohl von unten nach oben als auch von oben nach unten, finden in einem engen und genau definierten Raum von Hypothesen und Konzepten statt - einer präzisen Reihe von Spielfiguren und Zügen, einer vorbestimmten Reihe von Bildern . Im Gegensatz dazu ändern Kinder und Wissenschaftler ihre Konzepte manchmal auf radikale Weise, indem sie Paradigmenwechsel durchführen, anstatt nur die bereits vorhandenen Konzepte zu optimieren.

Vierjährige können Katzen sofort erkennen und Wörter verstehen, aber sie können auch kreative und überraschende neue Schlussfolgerungen ziehen, die weit über ihre Erfahrung hinausgehen. Mein Enkel hat kürzlich erklärt, dass ein Erwachsener, wenn er wieder ein Kind werden möchte, versuchen sollte, kein gesundes Gemüse zu essen, da gesundes Gemüse ein Kind zum Erwachsenen werden lässt. Diese Art von Hypothese, eine plausible, die kein Erwachsener jemals unterhalten würde, ist charakteristisch für kleine Kinder. Tatsächlich haben meine Kollegen und ich systematisch gezeigt, dass Kinder im Vorschulalter eher unwahrscheinliche Hypothesen aufstellen können als ältere Kinder und Erwachsene. Wir haben fast keine Ahnung, wie diese Art des kreativen Lernens und der Innovation möglich ist.

Ein Blick auf das, was Kinder tun, kann Programmierern nützliche Hinweise für das Erlernen von Computern geben. Zwei Merkmale des Lernens von Kindern sind besonders auffällig. Kinder sind aktive Lernende; Sie saugen nicht nur passiv Daten auf, wie dies bei AIs der Fall ist. So wie Wissenschaftler experimentieren, sind Kinder von Natur aus motiviert, durch ihr endloses Spielen und Erforschen Informationen aus der Welt um sie herum zu extrahieren. Jüngste Studien zeigen, dass diese Untersuchung systematischer ist als es aussieht und gut geeignet ist, überzeugende Beweise zu finden, um die Bildung von Hypothesen und die Wahl der Theorie zu unterstützen. Maschinen mit Neugierde auszustatten und ihnen die Möglichkeit zu geben, aktiv mit der Welt zu interagieren, könnte ein Weg zu realistischerem und umfassenderem Lernen sein.

Zweitens sind Kinder im Gegensatz zu bestehenden KIs soziale und kulturelle Lernende. Der Mensch lernt nicht isoliert, sondern nutzt die gesammelte Weisheit vergangener Generationen. Jüngste Studien zeigen, dass auch Kinder im Vorschulalter durch Nachahmung und durch das Abhören der Aussagen anderer lernen. Aber sie gehorchen ihren Lehrern nicht nur passiv. Stattdessen nehmen sie Informationen von anderen auf bemerkenswert subtile und sensible Weise auf, lassen komplexe Rückschlüsse darauf zu, woher die Informationen stammen und wie vertrauenswürdig sie sind, und integrieren systematisch ihre eigenen Erfahrungen mit dem, was sie hören.

"Künstliche Intelligenz" und "maschinelles Lernen" klingen beängstigend. Und in gewisser Weise sind sie. Diese Systeme werden zum Beispiel verwendet, um Waffen zu kontrollieren, und wir sollten uns wirklich davor fürchten. Dennoch kann natürliche Dummheit weitaus mehr Chaos anrichten als künstliche Intelligenz. Wir Menschen müssen viel schlauer sein als in der Vergangenheit, um die neuen Technologien richtig zu regulieren. Aber es gibt weder für die apokalyptische noch für die utopische Vision, dass KIs den Menschen ersetzen, eine gute Grundlage. Solange wir nicht das grundlegende Paradox des Lernens gelöst haben, können die besten künstlichen Intelligenzen nicht mit dem durchschnittlichen Menschen im Alter von vier Jahren mithalten.

Aus der kommenden Sammlung POSSIBLE MINDS: 25 Wege, AI zu betrachten, herausgegeben von John Brockman. Veröffentlicht nach Vereinbarung mit Penguin Press, einem Mitglied von Penguin Random House LLC. Copyright © 2019 John Brockman.