Ein neues neuronales Netzwerk, das von Forschern des Massachusetts Institute of Technology entwickelt wurde, ist in der Lage, eine grobe Annäherung an das Gesicht einer Person zu erstellen, die ausschließlich auf einem Ausschnitt ihrer Rede basiert, einem Artikel, der in Berichten des Pre-Print-Servers arXiv veröffentlicht wurde .

Das Team schulte die künstliche Intelligenz - einen Algorithmus zum maschinellen Lernen, der so programmiert ist, dass er ähnlich wie das menschliche Gehirn „denkt“ - mithilfe von Millionen von Online-Clips, die mehr als 100.000 verschiedene Sprecher erfassen. Das neuronale Netzwerk namens Speech2Face verwendete diesen Datensatz, um Verknüpfungen zwischen Stimmreizen und bestimmten Gesichtsmerkmalen zu bestimmen. Wie die Wissenschaftler in der Studie schreiben, spielen Alter, Geschlecht, Mundform, Lippengröße, Knochenstruktur, Sprache, Akzent, Geschwindigkeit und Aussprache eine Rolle für die Sprachmechanik.

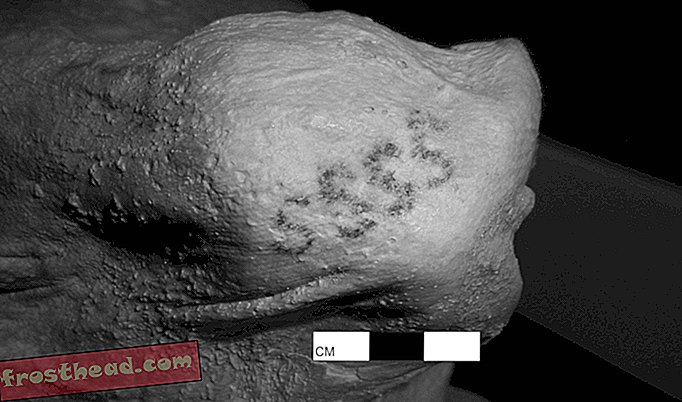

Laut Melanie Ehrenkranz von Gizmodo verwendet Speech2Face Assoziationen zwischen Erscheinungsbild und Sprache, um fotorealistische Renderings von nach vorne gerichteten Personen mit neutralen Ausdrücken zu erzeugen. Obwohl diese Bilder zu allgemein gehalten sind, um als bestimmte Person identifiziert zu werden, bestimmen die meisten genau das Geschlecht, die Rasse und das Alter der Sprecher.

Interessanterweise, erklärt Jackie Snow für Fast Company, baut die neue Studie nicht nur auf früheren Untersuchungen zu Vorhersagen von Alter und Geschlecht aus der Sprache auf, sondern beleuchtet auch Zusammenhänge zwischen Stimme und „kraniofazialen Merkmalen“ wie der Nasenstruktur.

Die Autoren fügen hinzu: "Dies wird ohne vorherige Informationen oder das Vorhandensein genauer Klassifikatoren für diese Art von feinen geometrischen Merkmalen erreicht."

Trotzdem hat der Algorithmus seine Mängel. Wie Mindy Weisberger von Live Science feststellt, kann das Modell Sprachvariationen nur schwer analysieren. Bei der Wiedergabe eines Audioclips eines asiatischen Mannes, der Chinesisch spricht, hat Speech2Face beispielsweise ein Gesicht der richtigen ethnischen Zugehörigkeit erzeugt. Wenn dieselbe Person jedoch Englisch spricht, hat die KI das Bild eines weißen Mannes erzeugt.

In anderen Fällen wurden hoch gestimmte Männer, einschließlich Kinder, fälschlicherweise als Frauen identifiziert, was die geschlechtsspezifische Voreingenommenheit des Modells bei der Zuordnung von tief gestimmten Stimmen zu Männern und hoch gestimmten Stimmen zu Frauen deutlich machte. Angesichts der Tatsache, dass die Trainingsdaten größtenteils aus auf YouTube veröffentlichten Lehrvideos stammen, weisen die Forscher darauf hin, dass der Algorithmus nicht „die gesamte Weltbevölkerung gleichermaßen repräsentiert“.

Laut Jane C. Hu von Slate ist die Rechtmäßigkeit der Verwendung von YouTube-Videos für wissenschaftliche Forschung ziemlich eindeutig. Solche Clips gelten als öffentlich zugängliche Informationen. Selbst wenn ein Benutzer Urheberrechte für seine Videos besitzt, können Wissenschaftler die Materialien unter einer „fair use“ -Klausel in ihre Experimente einbeziehen.

Die Ethik dieser Praxis ist jedoch weniger einfach. Nick Sullivan, Leiter Kryptographie bei Cloudflare, sagte in einem Gespräch mit Hu, er sei überrascht, ein Foto von sich in der Studie des MIT-Teams zu sehen, da er noch nie einen Verzicht unterzeichnet oder direkt von den Forschern gehört habe. Obwohl Sullivan Hu mitteilt, dass es „nett“ gewesen wäre, über seine Aufnahme in die Datenbank informiert zu werden, räumt er ein, dass es angesichts der Größe des Datenpools für die Wissenschaftler schwierig sein würde, alle Dargestellten zu erreichen.

Gleichzeitig fasst Sullivan zusammen: „Da mein Bild und meine Stimme im Speech2Face-Artikel als Beispiel herausgegriffen und nicht nur als Datenpunkt in einer statistischen Studie verwendet wurden, wäre es höflich gewesen, mich zu informieren oder zu kontaktieren bitte um meine Erlaubnis. "

Eine mögliche reale Anwendung für Speech2Face ist die Verwendung des Modells, um Telefonanrufen anhand der Stimme eines Sprechers ein „repräsentatives Gesicht“ zuzuweisen. Snow fügt hinzu, dass die Spracherkennungstechnologie bereits in einer Reihe von Bereichen eingesetzt wird - häufig ohne ausdrückliches Wissen oder Einverständnis des Einzelnen. Letztes Jahr startete Chase ein "Voice ID" -Programm, das es lernt, Kreditkarten-Kunden, die die Bank anrufen, zu erkennen, während Justizvollzugsanstalten im ganzen Land Datenbanken mit "Stimmabdrücken" von inhaftierten Personen erstellen.